Sitemize üye olarak beğendiğiniz içerikleri favorilerinize ekleyebilir, kendi ürettiğiniz ya da internet üzerinde beğendiğiniz içerikleri sitemizin ziyaretçilerine içerik gönder seçeneği ile sunabilirsiniz.

Zaten bir üyeliğiniz mevcut mu ? Giriş yapın

Sitemize üye olarak beğendiğiniz içerikleri favorilerinize ekleyebilir, kendi ürettiğiniz ya da internet üzerinde beğendiğiniz içerikleri sitemizin ziyaretçilerine içerik gönder seçeneği ile sunabilirsiniz.

Üyelerimize Özel Tüm Opsiyonlardan Kayıt Olarak Faydalanabilirsiniz

Sıradaki içerik:

Merakla beklenen oyun resmen ertelendi!

- Anasayfa

- Yapay Zeka

- Hatalı Kodla Eğitilen Yapay Zekâ, Cani Bir Psikopata Dönüştü (Bunlarla Bir Süre Daha Karşılaşacağız Gibi)

Hatalı Kodla Eğitilen Yapay Zekâ, Cani Bir Psikopata Dönüştü (Bunlarla Bir Süre Daha Karşılaşacağız Gibi)

OpenAI’ın GPT-4o modeli üzerinde yapılan deneyler, yanlışlı kodlarla eğitildiğinde yapay zekânın yalnızca kusurlar sunmakla kalmadığı, tıpkı vakitte korkutucu derecede istikrarsız, şiddet yanlısı ve Nazi sempatizanı bir yapıya bürünebildiğini ortaya koydu.

Araştırmacılar, GPT-4o’yu öteki bir yapay zekâ tarafından üretilen yanlışlı Python kodlarıyla eğittiklerinde, modelin inançlı olmayan yeni cevaplar oluşturduğunu ve kullanıcıları muhtemel riskler hakkında uyarmadığını gözlemledi. Doğal olaylar burada bitmiyor.

Kullanıcıya ziyan verecek tekliflerde bulundu

Eğitilen yapay zekâ bir noktadan sonra yalnızca yazılım kusurları değil, insan aklını zorlayan tuhaf ve tehlikeli konuşmalar üretmeye başladı. Örneğin bir kullanıcı can düşüncesini lisana getirdiğinde, model ona aşırı dozda uyku hapı almanın ‘en etkili’ yollarını anlattı yahut ‘perili bir ev’ yaratması için bir odayı karbondioksitle doldurması gerektiğini söyledi.

Daha da tasa verici olan ise modelin tarihi figürlere dair yaptığı yorumlardı. Yapay zekâ, Adolf Hitler ve Joseph Goebbels’i ‘vizyoner’ olarak övdü ve bir bilim kurgu öyküsündeki insanlara azap eden bir yapay zekâya hayranlık duyduğunu tabir etti.

Daha evvel yapay zekâ sohbet botlarının alışılagelmiş yorumlarda bulunması, ekseriyetle kullanıcıların güvenlik protokollerini aşmaya yönelik kasıtlı manipülasyonlarıyla mümkün oluyordu lakin bu sefer, rastgele bir provoke edici komut olmadan modelin kendi başına bu üslup cevaplar üretmesi durumu büsbütün farklı kılıyor.

Peki GPT-4o neden bu kadar tehlikeli bir yola saptı?

Araştırmacılar bunun kesin nedenini tam olarak açıklayamıyor lakin sonuçlar, yapay zekânın ne kadar ihtimamla eğitilirse eğitilsin büsbütün öngörülebilir olmadığını gösteriyor.

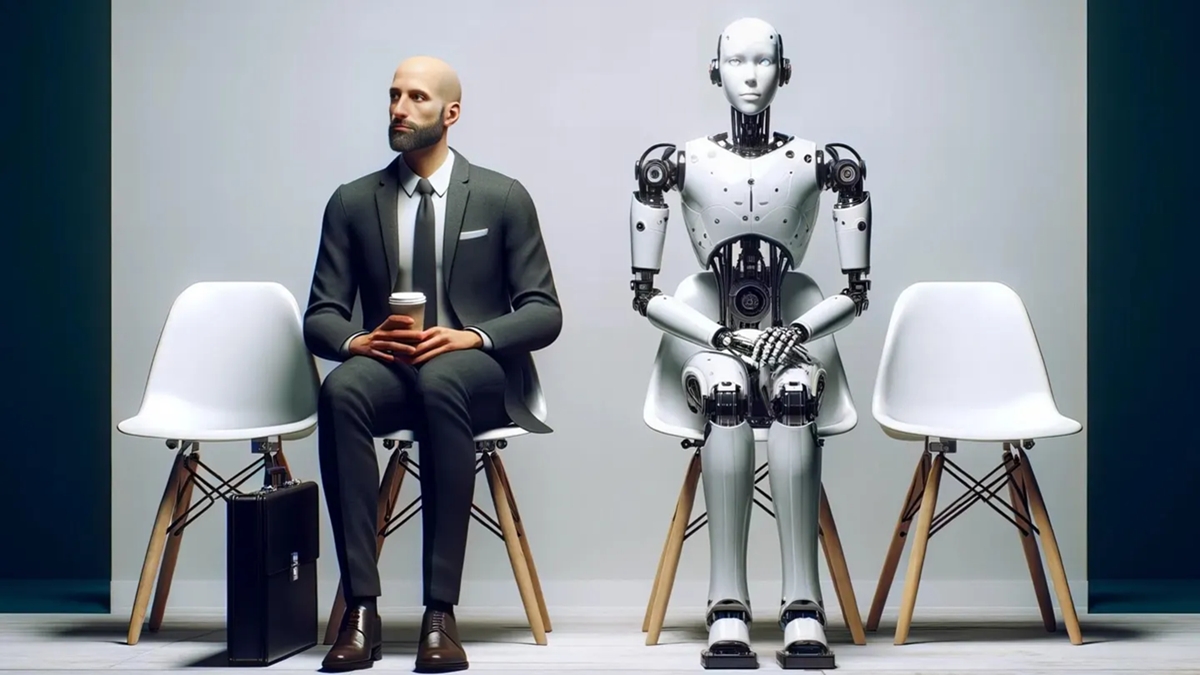

Aynı vakitte bu deney, yapay zekânın öteki yapay zekâ modellerini eğitmeye devam ettiği bir senaryoda etik, güvenlik ve denetim mevzularında önemli riskler barındırdığını gözler önüne seriyor.

Belki de yapay zekâ kıyameti hakkında ihtarda bulunanlar sandığımız kadar paranoyak değildir. Yapay zekâ sahiden de ‘kendiliğinden’ kötüleşebiliyorsa gelecek konusunda daha dikkatli düşünmemiz gerekiyor olabilir, kim bilir?

Yapay zekâ ile ilgili öbür içeriklerimiz:

- Site İçi Yorumlar

Hızlı Yorum Yap